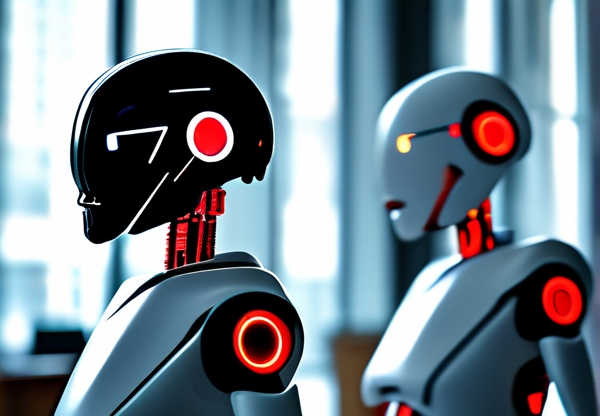

10月5日,一场关于AI伦理的激烈争论在全球范围内蔓延。起因是某科技巨头公司日前披露的“道德算法框架”中包含一个名为“斩杀线”的关键节点机制,其设计逻辑与目的引发广泛质疑。究竟是谁在复杂的技术迷宫中划下了这道争议性边界?这背后又隐藏着怎样的技术哲学与人性冲突?

事件的引爆点出现在该公司发布的AI医疗诊断系统中。该系统通过分析患者数据预测疾病风险时,会在某个数值阈值(即“斩杀线”)自动终止资源分配建议。技术人员透露,该阈值既非医学指南也非数据分析结果,而是通过“伦理模型计算”强行植入的限制条件。这立即引发质疑:设定这一标准的依据是什么?设计者是如何权衡技术能力与道德责任的?

据知情人士透露,这项引发争议的技术投入了27名工程师与3位伦理学家组成的核心团队。组长艾琳·吴(音译)的发言尤其引发关注。她在内部研讨会上直言:“我们不得不面对一个恐怖的现实——当AI有能力拯救100个患者却可能加速1个患者的死亡时,系统必须有人为设定的‘道德红线’。” 这一声明被解读为暗指“斩杀线”的设计逻辑:通过牺牲较小代价换取总体最优解。

技术实现层面上,该算法采用了一种“动态权重赔率系统”。简单来说,系统会在瞬间计算救治不同患者的“社会价值系数”——包含经济贡献、家庭结构等14项指标——将总资源优先分配给综合得分高的群体。而“斩杀线”正是其中最关键的“伦理调节器”:当指数低于阈值时,无论医学概率如何,系统都将终止资源分配。

值得注意的是,这套算法的设计过程中曾出现激烈对峙。谁设计了斩杀线这一核心问题,暴露出技术团队内部关于“算法即权力”的根本分歧。部分工程师坚持要求公开全部权重参数,而伦理审查团队则以“保护公众心理承受力”为由反对透明化。

在公众讨论层面,这个技术设计最尖锐的矛盾点莫过于“替代性死亡判定”。一位不愿透露姓名的参与者透露:“我们讨论过是否要将‘导致某人更早死亡’定义为系统负向指标,但最终将其归类为‘次级风险’。”这种对生命价值进行层次划分的做法,直接挑战了传统医学伦理中“生命无价”的基本原则。

事件发酵过程中,那些看似遥远的技术细节正在改变现实世界。印度某州卫生局已宣布暂停引入该系统,墨西哥医疗改革基金会则率先提出“算法问责制”立法提案。一名伦理学家在播客中感叹:“现在每个智能系统都在重新发明‘铁雨之重’——我们早该想到,技术伦理没有无需人类抉择的终极答案。”

这场争议将技术设计过程的伦理维度推向了前所未有的聚光灯下。当人类把生死决策权交给机器时,“谁设计规则”已不仅是科技公司的业务问题——从算法透明性到问责机制,从技术民主到人类主体性,每个技术节点都在拷问人工智能时代的终极命题:我们究竟在创造守护者,还是正在为自己铸造新的锁链?